La nouvelle version du générateur d’image de Google, Nano Banana Pro, a fait des vagues lors de la sortie de sa plus récente version, en novembre 2025. À ce moment-là, c’était le générateur d’image le plus performant – et il l’est encore aujourd’hui. Les images sont de meilleure qualité, ont une allure plus réaliste et ont beaucoup moins de défauts faciles à détecter.

Heureusement, c’est aussi le premier générateur d’image qui impose un filigrane invisible : SynthID. Toute image générée par Nano Banana Pro inclut cet identifiant. En demandant au grand modèle de langage (GML) de Google, Gemini, si une image est générée par intelligence artificielle (IA), il vous dira s’il a détecté SynthID dans l’image.

Et SynthID semble, pour l’instant, très difficile à contourner. Des journalistes, des créateurs et créatrices de contenu ainsi que des spécialistes ont mis SynthID à l’épreuve. L’identifiant numérique disparait seulement lorsque l’image est énormément altérée. Habituellement jusqu’à ne plus avoir l’air d’une photo réaliste.

Le filigrane est même détectable lorsque l’on prend une photo avec son téléphone de la photo sur son écran d’ordinateur et qu’on soumet cette capture à Gemini.

Aussi rassurant que puisse être l’inclusion de SynthID par cette entreprise qui a des tentacules dans presque tous les recoins du Web – et ce n’est pas si rassurant que ça – le trou noir de la désinformation et de la perte de confiance sur Internet demeure bien plus massif.

À lire aussi : Bonjour Gemini, au revoir nouvelles sur la francophonie

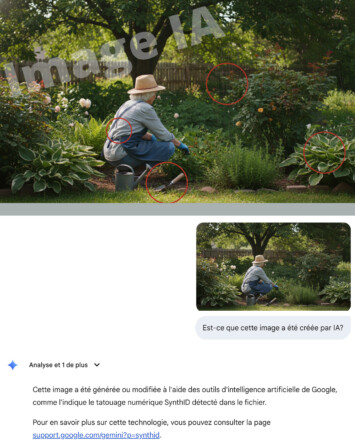

Cette photo a été produite dans la version gratuite de Nano Banana à partir de cette requête : «Une photo réaliste d’une vieille dame aux cheveux blancs, de dos, accroupis, en train de jardiner, avec des plantes vertes autour d’elle».

En agrandissant et inspectant de plus près, on peut voir que :

- il manque une bretelle au tablier;

- la pelle semble suspendue dans les airs;

- il y a une cage en métal qui ne soutient aucune plante;

- certaines feuilles de la plante en bas à droite se fondent les unes dans les autres.

L’image a été soumise à Gemini pour vérification. Le marqueur SynthID a bien été détecté.

Les limites de la détection

Que SynthID soit seulement détectable par Gemini est un défaut. Ça nous force à utiliser ce GML – plus polluant et énergivore que le produit original de Google –, ce qui augmente le nombre d’utilisateurs et d’utilisatrices et permet à l’entreprise de justifier l’existence de cette IA. Donc, Google a trouvé une solution à un problème qu’elle a aidé à créer…

Mais ça, c’est seulement si vous le faites. Soyez honnête : si vous êtes en plein milieu d’une séance de défilement morbide (traduction de l’Office québécois de la langue française pour doomscrolling) sur votre réseau social préféré et que vous tombez sur une image qui vous fait douter, allez-vous prendre le temps de vérifier?

Allez-vous prendre le temps de télécharger l’image, d’ouvrir Gemini, d’y mettre la photo et lui demander si c’est de l’IA?

Et si vous le faites et que l’image a été produite par un autre outil, il ne détectera pas de SynthID et vous ne serez pas plus avancé. Vous l’aurez compris, Google reste pour l’instant la seule entreprise à appliquer SynthID.

Au moins, pour l’instant, les autres générateurs d’images n’ont pas rejoint le niveau de réalisme de Nano Banana Pro. Le générateur d’images de ChatGTP est en ce moment la cible de moqueries parce qu’il produit des images de plus en plus jaunâtres. Ce serait un effet pervers de l’avoir entrainé sur sa propre production.

Pour ce qui est des autres outils qui disent pouvoir détecter les fausses images ou vidéo, ou même des textes, aucun n’est suffisamment fiable.

Quelques trucs

Il est encore possible de découvrir si une image ou une vidéo est réelle ou produite par une machine. Certaines techniques s’apparentent à la détection de fausses nouvelles. Voici quelques éléments sur lesquels se concentrer.

- Impression : Vous avez vu des photos toute votre vie. Mieux qu’une IA, votre cerveau s’est entrainé à reconnaitre la réalité. Si une image crée une réaction instantanée d’inconfort, méfiez-vous;

- Source : Vérifiez qui a publié l’image ou la vidéo. Est-ce que vous pouvez leur faire confiance? Certains comptes sur les réseaux sociaux ne font que produire du faux contenu (ne vous gênez pas pour les bloquer). La recherche par la Lentille Google peut aider à trouver la source originale d’une image repartagée;

- Anatomie : Il est plus rare de voir des mains à six doigts, mais les générateurs produisent encore des corps humains à l’anatomie peu probable, avec la peau soit trop lisse, une allure trop parfaite, des sujets qui ne regardent pas dans la bonne direction, avec une expression faciale qui détonne avec le sujet…;

- Lois de la physique : Portez une attention particulière aux ombres, aux perspectives, aux surfaces réfléchissantes. Dans le cas des vidéos, vous pourriez observer des réactions contraires à ce que prévoient les lois de la physique, comme des planches de bois qui plient, une structure impossible…;

- Le texte : Encore ici, les générateurs d’images se sont améliorés, mais ils produisent encore parfois du texte informe, qui ne fait aucun sens dans le contexte ou qui n’existe pas. Un exemple récent : beaucoup de vidéos circulent avec des agents qui ont un gros «ICE» blanc sur leur uniforme ou une veste pare-balle. Ce n’est pas ce qui est écrit sur les vestes des agents de la police de l’immigration des États-Unis;

- Instabilité : Ceci s’applique davantage aux vidéos. Concentrez-vous sur ce qui se passe autour de l’action principale d’une vidéo. Est-ce que des objets immobiles bougent ou «frémissent»? Est-ce que deux objets sont combinés de façon anormale? Est-ce que les visages en arrière-plan sont bizarres? Est-ce que la vidéo est d’une dimension non standard ou change constamment de cadrage (signe qu’on tente de cacher un logo)?

Le Réseau international de journalisme d’investigation propose un guide encore plus complet.

À lire aussi : L’IA générative à l’université : après la «panique totale», l’adaptation